Desde o advento da TV em branco e preto, com as primeiras tentativas de se transmitir imagens em movimento, os padrões de vídeo passaram por um processo constante de evolução. Hoje, os complexos padrões da TV digital que incluem algoritmos de compressão, dão uma mostra de que é possível transmitir grande quantidade de informações num canal estreito, sem perder a fidelidade. No entanto, para chegar a isso foi preciso muito trabalho, o que ficará patente ao analisarmos a evolução dos padrões de vídeo neste artigo. (2005)

Vídeo Analógico

O primeiro padrão de vídeo que surgiu foi para o sistema NTSC de transmissão de TV. Isso aconteceu em torno de 1930 com a adoção do padrão EIA RS-170.

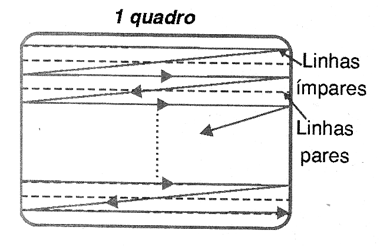

Nesse padrão eram usadas 525 linhas horizontais, das quais apenas 480 continham a informação de vídeo enviada pela câmera, enviadas numa taxa de 30 quadros por segundo, conforme mostra a figura 1.

Como os tubos de raios catódicos tendem a cintilar (flicker) a uma taxa tão baixa de reprodução de imagens como 30 Hz, foi utilizada a técnica de entrelaçamento com a transmissão de 60 campos por segundo.

Assim, cada quadro era dividido em dois campos, um dos quais enviando as linhas pares e outro as linhas ímpares da imagem.

Esse padrão também determinada que a transmissão e reprodução era feita com as linhas transmitidas de cima para baixo.

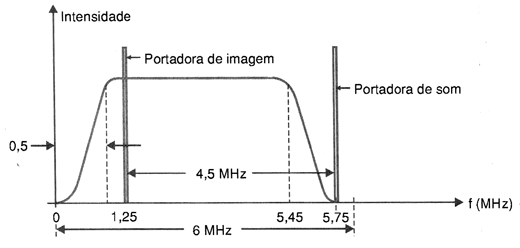

A faixa de freqüências necessária a transmissão deste tipo de sinal era da ordem de 4,5 MHz, com uma largura total de 6 MHz, para que o sinal de áudio também pudesse ser transmitido e haver ainda uma boa separação entre os canais, conforme mostra a figura 2.

Esse padrão ainda é usado exatamente como na forma criada original, mesmo depois de 75 anos.

Cor Analógica

Foi em torno de 1950 que surgiram as primeiras técnicas que permitiam usar o padrão analógico de vídeo anterior que era monocromático, para transmitir imagens em cores.

A informação de cor na forma analógica passou a ser agregada ao sinal na forma de uma sub-portadora separada, que os aparelhos monocromáticos não conseguiam detectar.

O método foi denominado NTSC (National Television Standards Council) e o padrão denominado RS-170A.

Ao mesmo tempo apareceram os padrões europeus PAL e SECAM. Esses padrões foram originalmente criados em função da freqüência da rede européia ser de 50 Hz, o que afetava bastante o problema da cintilação da imagem.

Assim, no padrão PAL temos 625 linhas horizontais por quadro numa taxa de 50 quadros por segundo. Variações para operar em redes de 60 Hz surgiram, como no caso do PAL-M adotado no Brasil.

Outros Padrões

Ao mesmo tempo, outros padrões foram criados, como o RS-343 ou padrões europeus STANAG.

Em torno de 1960 constatou que as aplicações que envolviam segurança exigiam uma resolução maior do que a obtida com os padrões de 525 linhas.

Assim, em 1969 aparecia o novo padrão RS-343 que regulamentava os sistemas de resoluções mais elevadas, chegando às 1023 linhas.

Atualmente a resolução mais adotada do RS-343 é a de 875 linhas, e existe um padrão RS-343A que prevê o uso de cores em alta resolução.

Também existe o padrão STANAG 3350 que estabelece de forma mais detalhada o uso de sinais de vídeo, conforme a seguinte tabela:

|

Padrão STANAG |

Método usado |

Base |

|

STANAG 3350 Classe A |

875 linhas x 60 quadros/s |

RS-343 |

|

STANAG 3350 Classe B |

625 linhas x 50 quadros/s |

PAL |

|

STANAG 3350 Classe C |

525 linhas x 60 quadros/s |

NTSC |

Padrões de Vídeo Composto

Os padrões anteriores se enquadram na categoria de "vídeo composto", como os utilizados na transmissão de TV comum.

Neste caso, existe um canal único de transmissão (ar, cabo, etc.) em que tanto os sinais de sincronismo como de vídeo em sí são combinados. Esse sinal é abreviado algumas vezes CVBS - Composite Video Broadcast SIgnal).

No entanto, existem sistemas em que são usados diversos cabos, e para isso também existe uma padronização.

S-Vídeo, RGB

Neste método, o sinal de brilho (luminância) é separada da da informação de cor, em dois cabos separados. Como resultado consegue-se maior resolução de cor, já que a mesma faixa de 4,5 MHz não precisa ser compartilhada pelos dois sinais.

Cada um dos sinais pode ter sua própria faixa de 4,5 MHz para a transmissão.

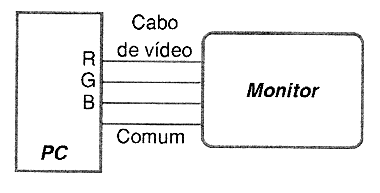

RGB

Neste caso, são usados três cabos, um para cada cor (R = red = vermelho, G = green = verde e B = blue = azul). Com isso pode-se usar os sinais para excitar diretamente os três canhões de um cinescópio em cores.

Nos sistemas de varredura progressiva, todas as linhas da tela são enviadas numa taxa de 60 quadros por segundo como, por exemplo, nos DVD players que são ligados à entrada monitor de um televisor.

A figura 3 mostra esses sinais.

Passando para o Computador

Com o advento dos computadores nos anos 1980 acentuou-se a necessidade de se obter vídeo com resoluções mais altas.

Essa necessidade tem como ponto de partida o fato de que os monitores de vídeo são usados mais próximos dos olhos dos operadores do que os televisores.

Os primeiros padrões foram o CGA e EGA, mas o que permaneceu foi o VGA com os decorrentes. Na tabela abaixo temos os principais padrões atuais VGA com suas resoluções:

|

Nome |

Resolução |

|

VGA |

640 x 480 |

|

SVGA |

800 x 600 |

|

XGA |

1024 x 800 |

|

SXGA |

1280 x 1024 |

|

UXGA |

1600 x 1200 |

Os padrões VGA são de varredura progressiva e o entrelaçamento não é usado.

Uma característica importante destes sistemas é que a taxa de transmissão é variável, dependendo apenas da fonte de sinais, não sendo portanto fixada pelo padrão.

A maioria dos sistemas atuais operam com 75 quadros por segundo (FPS = frames per second) ou ainda em velocidades maiores.

Um ponto importante que deve ser considerado na transmissão de imagens é o seu sincronismo. Existem diversos métodos para se fazer a sincronização vertical para se indicar o ponto de inicio de um quadro e a sincronização horizontal para se indicar onde começa uma linha.

Para as aplicações RGB temos três métodos usados:

1. RGB, V, H - O sincronismo horizontal e vertical são enviados em linhas separadas. Isso significa a necessidade de 5 cabos para a transmissão do sinal.

2. RCG com Sincronismo Composto - Neste caso, o sincronismo horizontal e vertical formam um sinal de sincronismo composto. de modo que o cabo usado precisa de apenas 4 condutores.

3. RGB Sincronismo no Verde - Neste caso, o sincronismo horizontal e vertical são superpostos no sinal G (verde) exigindo-se assim apenas três condutores para os sinais.

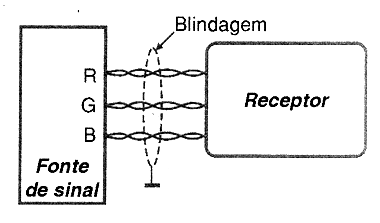

Um tipo interessante de sinal utilizado para transmissão de vídeo é o RGB Diferencial (Differential RGB).

Este tipo é empregado em aplicações militares. Em lugar de se enviar um sinal RGB ativo através de três condutores, eles são enviados em três pares diferenciais, conforme mostra a figura 4.

O sinal é então dado pela diferença de tensão entre os condutores de cada par. A vantagem desse sistema é que ele elimina a influência de ruídos no sinal, pois ele é cancelado.

Vídeo Digital

Nos anos 1990, a tendência que se manifestou foi a de que a TV comum analógico passaria rapidamente para a forma digital.

Os motivos são óbvios: a transmissão digital não tem o problema da degradação da imagem em caso de retransmissão. Fantasmas e outros problemas não existem nessa modalidade de transmissão.

Outra vantagem está na possibilidade de se comprimir o sinal de tal forma, que uma considerável redução da faixa passante necessária a sua transmissão pode ser conseguida.

Um sinal comprimido pode ser transmitido ou armazenado com muito mais facilidade.

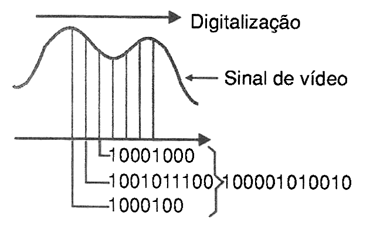

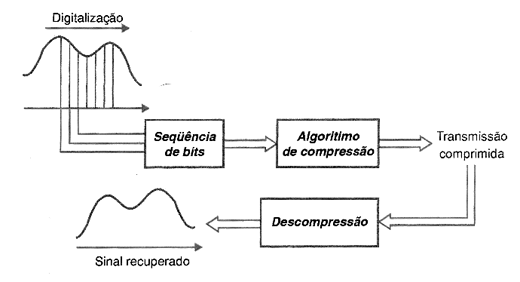

O que ocorre com um sinal de vídeo digitalizado é que a imagem é fragmentada em pixéis (unidades de imagem) individuais que são transmitidos seqüencialmente tanto em sistemas paralelos como seriais, conforme mostra a figura 5.

Os pixéis de imagens em cores são transmitidos no formato de 24 bits sendo 8 bits para o vermelho, 8 bits para o verde e 8 bits para o azul.

Existe ainda um formato de 32 bits em que temos 8 bits extras acrescentados para a "transparência". Esse valor extra acrescentado é denominado "alfa".

Exatamente como um sinal de vídeo analógico, os pixéis digitalizados são enviados seqüencialmente partindo do extremo superior esquerdo da imagem para o extremo inferior direito, linha a linha. Nos padrões entrelaçados as linhas transmitidas são separadas em campos pares e ímpares.

O padrão que determina a transmissão de sinais NTSC/RS-170ª é o ITU656.

A velocidade com que a amostragem é feita é um outro ponto a ser considerado no vídeo digital.

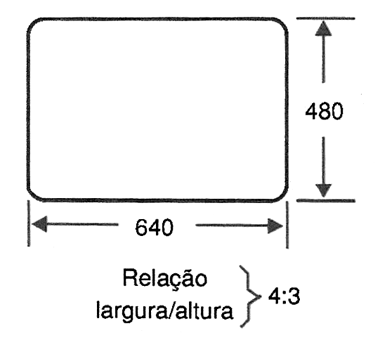

Para aplicações em TV de alta definição e DVD, uma taxa de 720 amostragem por linha é feita. No entanto, essa taxa não resulta em pixéis quadrados.

Para se obter pixéis quadrados são feitas 640 amostragem por linha. Assim, como temos 480 linhas ativas numa imagem padrão de TV, obtém-se o formato 640 x 480 que justamente resulta numa relação 4:3 para a imagem, conforme mostra a figura 6.

Quando se passa para os estúdios, os sinais são em sua maioria digitais, usando o interfaceamento digital ou SDI - Serial Data Interface.

Para uma definição padrão, como as empregadas na televisão comum, os dados são transmitidos a uma velocidade de 270 megabits por segundo. O padrão empregado neste caso é o SMPTE 259.

SMPTE significa Society of Motion Picture and Television Engineers.

Para a televisão de alta definição, temos o HI-SDI utilizando o padrão SMPTE 292M em que a taxa de transmissão é de 1,485 gigabits por segundo.

Nesses padrões os dados são enviados por um cabo coaxial único de 75 Ω na forma de pacotes de 10 bits.

Vídeo Para Monitores

Um outro avanço que está ocorrendo no mundo dos sinais de vídeo é a mudança dos sinais analógicos (RGB ou vídeo composto) para interfaces digitais usando a Digital Video Interface ou DVI.

Com a transmissão digital novamente temos a vantagem de que não ocorre qualquer degradação da imagem entre o computador e o monitor.

Nesse padrão o sinal de vídeo é enviado por 4 pares diferenciais blindados numa formato e resolução determinado pela interface gráfica.

A velocidade pode chegar a 1 gigabit por segundo em cada par. Deve-se considerar a limitação de comprimento dos cabos, sendo esse padrão indicado para conexões curtas.

Padrões de Compressão

Conforme já observamos neste artigo, uma das grandes vantagens do vídeo digital está no fato de que a informação de um sinal pode ser comprimida, o que ajuda a reduzir a banda passante necessária a sua transmissão além de facilitar o seu armazenamento (exigindo menos espaço na mídia).

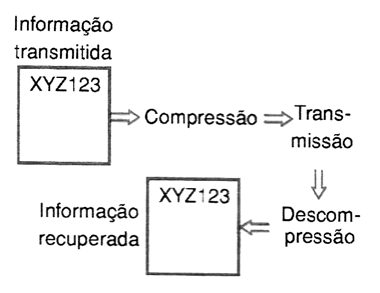

Existem duas formas de compressão de dados: com perdas e sem perdas.

A compressão sem perdas é usada quando se deseja recuperar os dados exatamente da mesma forma que eles eram antes da compressão.

Textos e informação numérica, por exemplo, não podem ter nenhum caractere o algarismo faltando depois de recuperado de uma transmissão comprimida, conforme mostra a figura 7.

Texto e informações numéricas devem, portanto, ser transmitidos com a ajuda de sistemas de compressão sem perdas. As codificações Huffman, Lempel-Ziv-Welch (LZW) são exemplos de codificações sem perdas para textos.

Para imagens podem ser usada a Portable Network Graphics (PNG), que é recomendada pelo World Wide Web Consortion e que é também um padrão ISO.

Um dos problemas para a compressão sem perdas é o grau máximo em que ela pode ser aplicada e ainda funcione.

Normalmente, as taxas de compressão sem perdas estão na faixa de 2:1 a 8:1.

No caso da compressão com perdas parte-se da idéia de que os dados não precisam ser recuperados totalmente.

Assim, numa imagem, os dados redundantes podem ser simplesmente eliminados. Com isso pode-se obter uma taxa de compressão muito maior. No caso dos sons, as freqüências que não são ouvidas em determinadas condições, podem também ser eliminadas.

Para a compressão de sinais de vídeo trabalharam durantes os últimos anos dois grandes grupos: o Moving Picture Experts Group (MPEG) e o International Telecommunication Union (UTI), que desenvolveu os padrões da série H, principalmente para aplicações em telecomunicações.

Existem atualmente diversos padrões MPEG em usado, desenvolvidos para aplicações específicas, a partir do MPEG-1.

MPEG-1

Foi o primeiro padrão de compressão com perdas desenvolvido pelo comitê e ainda está em uso nos dias para compressão de vídeo em CD-ROM.

O Windows Media Player usa esse padrão. A compressão é obtida por um algoritmo que usa técnicas com o uso da Transformada Discreta de Cosseno (DCT) convertendo inicialmente cada imagem no domínio das freqüências e dois processando os coeficientes de modo a reduzir da maior forma possível a informação a ser transmitida, conforme mostra a figura.8.

O DCT é similar a Transformada Rápida de Fourier obtendo-se uma imagem com boa qualidade principalmente quando são transmitidos movimentos lentos.

A taxa de compressão obtida com esse padrão chega aos 10:1.

MPEG-2

Esse padrão foi desenvolvido para suportar a compressão de imagens de alta qualidade como as usadas em DVDs e TB digital via satélite, tendo sido criado em 1994.

A taxa de transmissão varia de 5 a 8 Mbps, se bem que não exista uma limitação. Além de suportar vídeo entrelaçado, o padrão usa transformadas DCT.

O sistema também prevê a transmissão de áudio e cores com extensões multicanal e para som surround. É o padrão usado atualmente na TV de alta definição (HDTV).

MPEG-3

Esse padrão também foi criado para atender às necessidades da TV de alta definição, com a capacidade de manusear sinais numa taxa ainda maior de transmissão, entre 20 e 40 Mbps.

Esse padrão foi descontinuado, não dependendo ser confundido com o MPEG-1 Camada 3 (layer 3) que é o conhecido MP3.

MPEG-4

O Padrão de compressão MPEG-4 foi introduzido em 1998, sendo designado para manusear sinais de baixa velocidade, de 4800 bps a 4 Mps.

As aplicações incluem o videofone e a TV digital. Esse padrão absorve diversas características do MPEG-1 e 2, tendo sido publicado como norma ISO 13818.

O MPEG-3 é usado para codificar sinais de vídeo incluindo algumas características como VRLM (Virtual Reallity Modelling Language "vermal") para representação de gráficos 3D.

Uma característica do MPEG-4 é que características adicionais do sistema podem ser acrescentadas pelo desenvolvedor.

Conclusão

Os padrões de vídeo e de compressão estão aí, com aplicações múltiplas em diversos tipos de equipamentos e campos de transmissão ou gravação.

O conhecimento básico de onde cada um é usado e como funciona é importante para se trabalhar com a compatibilidade dos equipamentos.

O que vimos neste artigo é uma breve análise dos padrões existentes e suas principais características.