Nessa série de artigos temos analisado os fundamentos do MPEG assim como seus protocolos. No artigo anterior tratamos da compressão da imagem e dos tipos de imagens com que o MPEG trabalha. Continuamos essa série agora analisando a compressão do áudio, pois tão importante como a imagem é som que a acompanha e que deve ser reproduzido com fidelidade. O que publicamos aqui, dado o espaço limitado disponível, é uma versão compacta obtida de documentação da Tektronix (A Guide to MPEG Fundamentals and Protocol Analysis).

Este artigo é de 2006 quando ainda não estava definido o padrão de TV digital a ser usado em nosso país.

Esta série é formada pelos artigos TEL138 a TEL143

A compressão dos sinais de áudio com perdas é baseada inteiramente nas características do ouvido humano.

Surpreendentemente, o ouvido humano não é tão crítico para os sons estereofônicos em termos de discriminação como é o caso a visão.

Assim, a compressão de áudio não precisa ser tratada de uma forma tão intensa como a da imagem.

A Audição Humana

A audição ocorre através de processos físicos no ouvido e no sistema nervoso que se combinam para nos dar as sensações sonoras.

A sensação que temos não é exatamente a mesma que corresponde à forma de onda presente no canal auditivo porque alguma entropia é perdida.

A faixa de freqüências de ressonância da membrana basilar determina a faixa auditiva humana, normalmente indo de 20 Hz a 15 Hz.

Essa faixa muda conforme a idade e de pessoa para pessoa.

Freqüências diferentes na entrada fazem com que diferentes áreas da membrana vibrem.

Cada área tem terminações nervosas diferentes para permitir a determinação da nota correspondente.

A membrana basilar também possui músculos delicados controlados pelos nervos que, agindo em conjunto, funcionam como um sistema de feedback positivo capaz de aumentar o fator Q na ressonância.

Esse limiar ressonante da membrana basilar é exatamente igual ao limiar de um analisador de transformada.

De acordo com a teoria da incerteza das transformadas, mais preciso é o domínio de freqüências de um sinal, menos precisamente o domínio dos tempos é conhecido.

Consequentemente, quanto maior for a capacidade de uma transformada de discriminar duas freqüências, menos ela será capaz de discriminar o tempo entre dois eventos.

O ouvido humano tem um certo compromisso que equilibra a discriminação pela incerteza no tempo com a discriminação pela incerteza da freqüência.

Nesse equilíbrio nenhuma das duas capacidades é perfeita.

O resultado de uma discriminação imperfeita de freqüência é a incapacidade que temos de separar freqüências que estejam muito próximas.

Essa inabilidade é conhecida como mascaramento auditivo e é definida como a sensibilidade reduzida a um som em presença de outro.

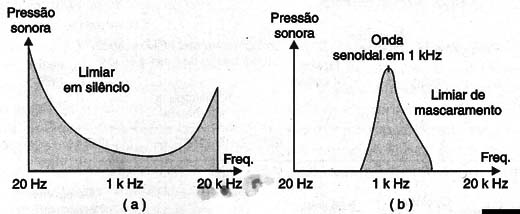

A figura 1(a) mostra como o limiar da audição é função da freqüência do som.

A maior sensibilidade, como é de se esperar, ocorre justamente na faixa da nossa fala.

Na presença de um simples tom, o limiar é modificado, conforme mostra a figura 1(b).

A discriminação imperfeita de tempos pelo ouvido é devido à sua resposta ressonante.

O fator Q é tal que para um determinado que esteja presente por pelo menos 1 milissegundos antes, ele se torna audível.

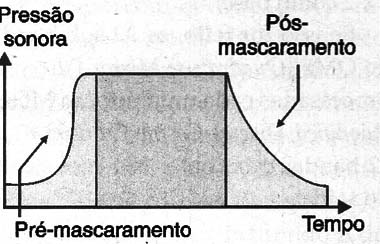

Devido a essa baixa resposta, o mascaramento também pode ocorrer mesmo quando os dois sinais envolvidos não estejam presentes simultaneamente.

O mascaramento adiante e atrás ocorre quando o som que mascara continua a mascarar sons em níveis mais baixos antes e depois da duração do som real. A figura 2 mostra o que ocorre.

O mascaramento alcança o limiar da audição e os compressores tiram vantagem desse efeito aumentando o piso de ruído, o que permite que uma forma de onda seja expressa com menos bits.

Codificação de Sub-banda

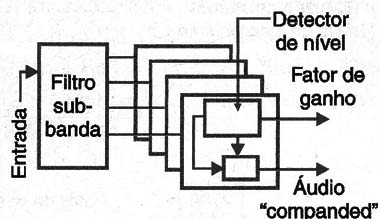

Na figura 3 mostramos um compander que faz a separação de bandas ou “band-spliting”.

O filtro de divisão de bandas é um conjunto de filtros de fase linear e faixa estreita que têm todos a mesma largura de faixa.

A saída de cada banda consiste em amostras representando uma forma de onda.

Em cada banda de frequência a entrada de áudio é amplificada ao nível máximo permitido para a transmissão.

Depois disso, cada nível é levado de volta ao seu valor correto.

O ruído captado na transmissão é reduzido em cada banda.

Se a redução de ruído for comparada com o limiar da audição em cada banda pode-se ver que ruídos maiores podem ser tolerados em certas bandas devido ao mascaramento.

Dessa forma, em cada banda, depois do processo de “companding” é possível reduzir o tamanho das palavras de amostragem.

Essa técnica consegue compressão porque o ruído de quantização introduzido pelas perdas de resolução é mascarado.

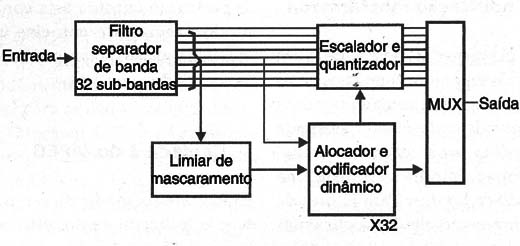

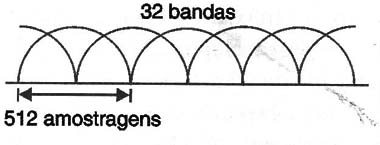

A figura 4 mostra um simples codificador divisor de banda como usado na camada 1 do MPEG.

A entrada de áudio digital e aplicado a um filtro divisor de bandas que divide o espectro num certo número de bandas.

No MPEG esse número é 32. O eixo dos tempos é dividido em blocos de igual comprimento.

Na camada 1 do MPEG existem 384 entradas de amostragem, assim, existem 12 amostragens em cada uma das 32 bandas na saída do filtro.

A saída do banco de filtros para a camada 1 MPEG é analisada usando uma FFT de 512 pontos de modo a determinar o espectro do sinal de entrada.

Essa análise cria um modelo de mascaramento que determina o grau de mascaramento que deve ser esperado em cada banda.

Camada 1 do MPEG

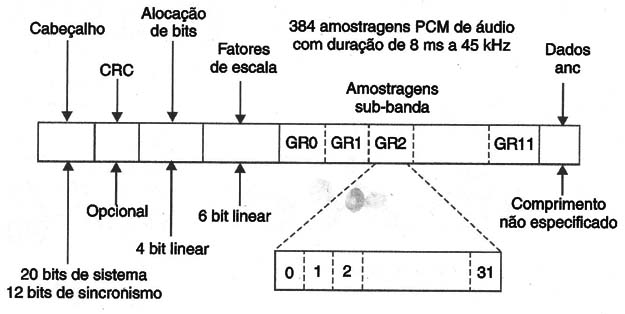

A figura 5 mostra a camada 1 de áudio do MPEG.

Seguindo o padrão de sincronismo e o cabeçário, existem 32 bits de códigos de alocação, com quatro bits cada um.

Esses códigos descrevem o comprimento da palavra das amostragens em cada sub-banda.

Depois vêm 32 fatores de escala usados para o companding de cada band.

Esses fatores de escala determinam o ganho necessário no decodificador para retornar o sinal de áudio ao seu nível original.

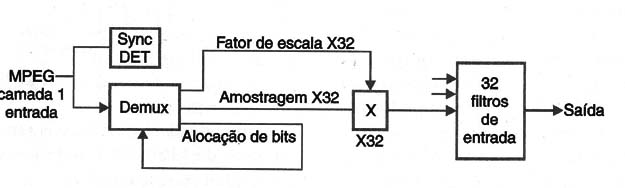

Os fatores de escala são seguidos, por sua vez, pelos dados de áudio em cada banda. A figura 6 mostra um decodificador da camada 1.

Camada 2 do MPEG

A figura 7 mostra que quando um filtro separador de banda é usado para excitar o modelo de mascaramento, a análise espectral não é muito precisa, já que existem apenas 32 bandas e a energia poderá estar em qualquer parte da banda.

O piso de ruído não pode ser elevado muito porque, no pior caso mostrado, o mascaramento pode não operar. Uma análise espectral mais precisa pode permitir um fator de compressão maior.

No MPEG camada 2, a análise espectral é realizada por um processo separado.

Em lugar disso, uma FFT (Fast Fourier Transform) de 1024 pontos trabalha diretamente a partir da entrada e é usado para excitar o modelo de mascaramento.

Para resolver as freqüências de um modo mais preciso o espalhamento de tempo da transformada não é aumentado, o que é feito é aumentar o tamanho do bloco para 1152 amostragens.

Codificação de Transformada

As camadas 1 e 2 são baseadas em filtros separadores de banda nos quais o sinal é ainda representado por uma forma de onda.

No entanto, a camada 3 adota uma codificação de transformada similar ao que é usado na codificação de vídeo.

Para fatores de compressão elevados os coeficientes podem ser requantizados, tornando-os menos precisos.

Esse processo produz ruído que aparecerá nas freqüências onde o mascaramento é maior.

Uma finalidade de um codificador de transformada é fazer com que o espectro de entrada seja conhecido de modo preciso, de modo que um modelo preciso de mascaramento possa ser criado.

Camada 3 do MPEG

Uma transformada discreta de cosseno é usada tendo 384 coeficientes por bloco.

A saída pode ser obtida pelo processamento direto nas amostragens de entrada, mas com um código multi-nível é possível usar uma transformada híbrida incorporando as 32 camadas de filtragem das camadas 1 e 2 como base.

Se isso for feito, as 32 sub-bandas do QMF (Quadrature Mirror Filter) são cada uma processadas por um MDCT (Modified Discret Cosine Transform) de 12 bandas para obter 384 coeficientes de saída.

Áudio MPEG-2

Apesar de originalmente designados como áudio MPEG níveis 1, 2 e 3, os sistemas são agora conhecidos de forma mais precisa como MPEG-1 nível 1, etc. MPEG-2 define extensões para o áudio MPEG-1, e um sistema mais avançado de codificação.

O MPEG-2 permite o uso de uma amostragem a taxas mais baixas que o MPEG-1.

Isso não significa que haja uma compatibilidade decrescente, mas requer apenas tabelas adicionais e um decodificador adicional MPEG-1 para interoperabilidade.

O áudio MPEG-2 BC (Backward Compatible) proporciona canais 5:1 (cinco canais de banda completa mais um canal de baixa largura de faixa para efeitos de baixa freqüências).

O MPEG-2 BC tem um fluxo de bits MPEG-1 (2 canais) no seu cerne e adicional extensões multi-canais numa forma que possa ser ignorada por um decodificador MPEG-1.

O MPEG-2 AAC (Advanced Audio Coding) é um sistema mais sofisticado com bancos de filtros alta resolução e ferramentas adicionais de codificação. Ele oferece uma eficiência mais elevada na codificação, mas não tem compatibilidade decrescente.

Audio MPEG-4

A codificação MPEG-4 é baseada em objetos.

Os objetos MPEG-4 podem representar sons naturais ou sintéticos.

Para a codificação de sons naturais, o conjunto de ferramentas MPEG-4 inclui um MPEG-2 AAC assim como uma variedade de outras ferramentas.

Elas incluem codificação paramétrica para taxas de bits muito lentas e uma técnica de codificação denominada “code excited linear predictive” (CEL)) para palavra e que opera na faixa das médias freqüências.

Várias formas de escalabilidade são suportadas, incluindo a de fluxo de bits que pode ser aplicadas a pontos do sistema de transmissão.

AC-3

A técnica de codificação de áudio AC-3, inventada pelos laboratórios Dolby, é usada com o sistema ATSC em lugar de esquema de codificação de áudio MPEG.

Ela está documentada nos padrões ATSC a/52. Subsequentemente, o AC-3 adotou um componente opcional de DVB e pela Motorola o sistema Digicypher II.

OS PADRÕES MPEG

MPEG significa Moving Pictures Experts Group, um comitê que foi formado sob o controle da International Standards Organization (IEC).

O IEC controla a padronização internacional das tecnologias elétricas e eletrônicas e o ISO trata praticamente de tudo mais.

No início da era da tecnologia, ISO e IEC formavam um conjunto de comitês técnicos JTC1 que tratava dos assuntos IT.

O JTC1 possui diversos grupos de trabalho, incluindo o JPEG (Joint Photographic Experts Group) e o WG11, que é o MPEG.

MPEG-1

O sistema MPEG-1 ISO/IEC 11172 é o primeiro padrão internacional de compressão para imagem em movimento tendo sido desenvolvido entre 1988 e 1992.

Esse sistema usa transformadas DCT, quantização de coeficientes e codificação com comprimento variável. De forma similar ao JPEG, ele também inclui compensação de movimento para a compressão temporal. O MPEG-1 é dividido em três partes:

Sistema ISO/IEC 11172-1 – estrutura de multiplex

ISO/IEC 11172-1 – codificação de vídeo

ISO/IEC 11172-3 – codificação de áudio

O MPEG-1 representa uma grande conquista técnica.

Ele foi projetado para comprimir fluxos de imagem com imagens do tamanho SIF, 352 x 288 (PAL 25 Hz) ou 36\52 x 240 (NTSC 30 Hz) e áudio associado, para aproximadamente 1,5 Mbits/s de velocidade total para os dados comprimidos.

O formato CIF é um compromisso entre os formatos SIF europeu e americano (source input format): resolução especial para 625 SIF (352 x 288) e resolução temporal 525 SIF (29,97 Hz).

Essa é a base da vídeo conferência.

MPEG-2

O MPEG-1 foi congelado em 1991. Apenas as mudanças subseqüentes foram acrescentadas apenas na forma editorial.

No mesmo ano o processo MPEG-2 foi iniciado e ele se tornou praticamente um padrão em 1994.

As metas iniciais eram simples: era necessário um padrão que acomodasse vídeo nas faixas disponíveis na TV comercial.

Isso exigia uma codificação “full size” das imagens com definição padronizadas (704 x 480 em 29,97 Hz e 704 x 576 em 25 Hz), além da capacidade de trabalhar com códigos de vídeo entrelaçado de maneira eficiente.

De muitas formas, o MPEG-2 representa a “era de chegada” do MPEG.

A maior flexibilidade do MPEG-2 combinada com o aumento da disponibilidade de circuitos integrados em larga escala, significa que o MPEG-2 pode ser usado numa grande quantidade de aplicações.

O MPEG-2 é documentado como ISO/IEC 13818, atualmente em 10 partes. As partes mais importantes do padrão são:

ISO/IEC 13818-1 – Sistema (correntes de transporte e programas), PES, modelo de buffer T-STD e tabelas básicas PSI: CAT, PAT, PMT e NIT.

ISO/IEC 13818-2 – Codificação de vídeo

ISO/IEC 13818-3 – Codificação de áudio

ISO/IEC 13818-4 – Conformidade e testes MPEG

ISO/IEC 13818-5 – Difusão de dados e DSMCC

Perfis e Níveis no MPEG-2

Com algumas pequenas exceções, o MPEG-1 foi projetado para uma tarefa: a codificação de imagens de tamanho fixo e áudio associado para uma taxa de bits de 1,5 Mbits/s.

As ferramentas do MPEG-1 e sintaxe podem ser usadas para outras finalidades, mas o uso fora do padrão exige codificadores e decodificadores licenciados.

Existe apenas um tipo de decodificador compliante com o padrão MPEG-1.

Por outro lado, existe uma meta similar para o MPEG-2.

Ele foi destinado a codificação de imagens de difusão e som, nominalmente nos formatos 525/60 e 625/50, dos sistemas entrelaçados de TV.

Na prática não existe um único decodificador MPEG-2.

Se um decodificador compliante for capaz de manusear as correntes de bits de alta velocidade codificada usando todas as ferramentas possíveis, ele seria uma solução econômica para diversos tipos de aplicações.

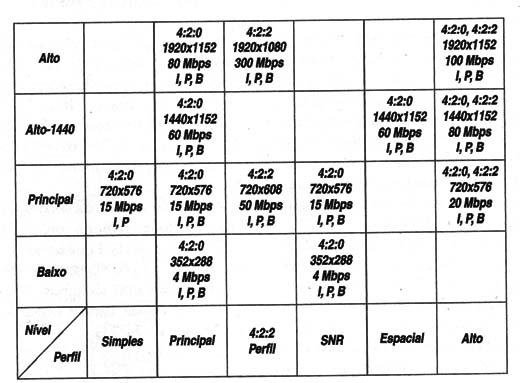

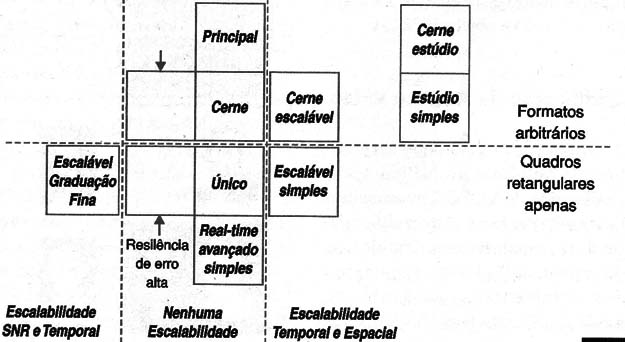

O MPEG apresenta duas estruturas bi-dimensionais de perfis e níveis para classificação de correntes de bits e decodificadores.

Os perfis definem as ferramentas que devem ser usadas.

Por exemplo, uma codificação bidirecional (Quadros B) deve ser usada no perfil principal, e não em perfil simples.

Os níveis mostram como escalar. Um decodificador de alto nível deve ser capaz de receber uma corrente de bits mais rápida, e deve ter mais buffer de decodificação e um armazenamento maior de quadros do que um decodificador do nível principal.

A figura 8 mostra os pares de perfis e níveis que são definidos pelo MPEG-2 (perfis no eixo horizontal e níveis no eixo vertical).

Note que nem todas as combinações são válidas.

Apenas as que possuem pares completos são definidas no padrão. Isso é uma exigência de conformidade do padrão que um decodificador em qualquer perfil/nível deve ser capaz de decodificar sinais de perfis e níveis mais baixos.

Por exemplo, um decodificador MP@ML deve ser capaz de decodificar o perfil principal de baixo nível MP@LL, e correntes de bits SP@ML.

Como uma alternativa, codificando apenas as baixas freqüências especiais numa imagem de HDTV, pode-se produzir um fluxo principal de bits o qual pode ser decodificado por um receptor convencional SDTV.

Se a imagem de baixa definição é localmente decodificada e subtraída da imagem original, uma imagem de melhor definição será obtida.

A imagem pode então ser codificada com um sinal de ajuda. Um decodificador apropriado pode combinar o sinal principal com sinais de ajuda para receber imagens HDTV. Esse é o princípio da escalabilidade especial.

O perfil alto suporta tanto escalabilidade SNR como espacial, assim como permite a opção de amostragem 4:2:2,

O perfil 4:2:2 foi desenvolvido para uma compatibilidade melhorada com os equipamentos de produção digital. Esse perfil permite a operação 4:2:2 sem a necessidade de complexidade adicional de se usar o alto perfil.

Por exemplo, um decodificador HP@ML pode suportar escalabilidade SNR que não é uma exigência para produção.

O perfil 4:2:2 tem a mesma liberdade de uma estrutura GOP como outros perfis, mas na prática é comumente usada com GOPs curtos, facilitando a editoração.

MPEG-4

Mesmo quando um padrão é oficialmente adotado, existem ainda muitas melhorias que podem ser feitas assim como extensões que podem ser criadas.

Assim foi com o MPEG-2.

Como vimos o MPEG-3 foi iniciado e abandonado, de tal forma que o projeto seguinte foi o MPEG-4.

Duas versões do MPEG-4 já estão completas e mesmo assim, o trabalho de se criar novas extensões continua.

O principal objetivo do MPEG-4 é codificar vídeo e áudio e taxas muitas baixas.

De fato, o padrão foi padronizado para três taxas de bits:

Abaixo de 64 kbit/s

De 64 kbits/s a 384 kbits/s

De 384 kbits/s a 4 Mbits/s

O desempenho em baixas taxas de bits permanece o maior objetivo e algumas idéias muito criativas contribuíram para essa finalidade.

Muita atenção foi também dada aos erros, tornando o MPEG-4 muito apropriado para ser utilizado em ambientes sensíveis a erros, como nos equipamentos portáteis de uso pessoal.

Documentos do Padrão MPEG-4

As principais partes do padrão MPEG-4 são:

ISO/IEC 14496-1 – Sistemas

ISO/IEC 14496-2 – Visual

ISO/IEC 14496-3 – Áudio

ISO/IEC 14496-4 – Teste de conformância

ISO/IEC 14496-6 – DMIF (Delivery Multimidia Integration Framework)

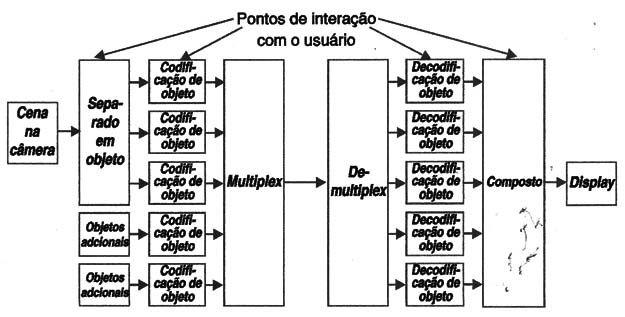

Codificação à Objeto

A ideia mais importante dos sistemas convencionais de transmissão é o conceito de objeto.

As diferentes partes de uma cena final podem ser codificadas e transmitidas separadamente como objetos de vídeo e objetos de áudio para serem tratadas juntos ou compostos pelo decodificador.

Diferentes tipos de objetos podem ser cada um codificado com uma ferramenta mais apropriada para a tarefa.

Os objetos podem ser gerados independentemente, ou uma cena analisada para separação, por exemplo, os objetos de primeiro e segundo plano, como ocorre numa partida de futebol em que a bola pode ser processada separadamente da cena.

Um diagrama de blocos na figura 9 mostra o sistema de codificação orientado a objeto MPEG-4.

Codificação de Áudio e Vídeo

Muitas das ferramentas de codificação de vídeo no MPEG-4 são similares às do MPEG-2, mas melhoradas pelo melhor uso da codificação preditiva e mais eficiente codificação da entropia.

No entanto, a aplicação das ferramentas pode diferir de modo significativo em relação às dos padrões anteriores.

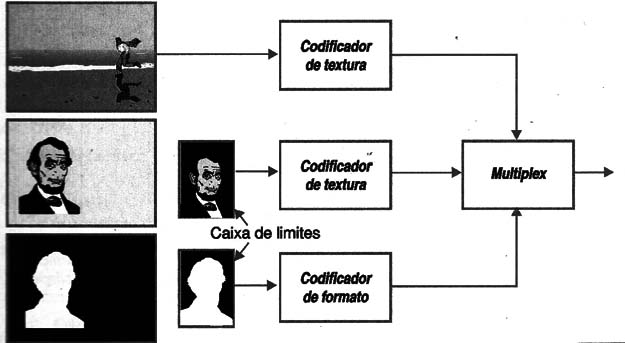

O MPEG-4 codifica objetos de vídeo. No modelo mais simples um vídeo é codificado da mesma forma que no MPEG-2, mas é descrito como um simples objeto de vídeo com um formato retangular.

A representação da imagem é conhecida como codificação de textura.

Onde não existe mais do que um objeto de vídeo, alguns podem ter formatos irregulares e geralmente menores do que o fundo de tela.

Isso significa que apenas a área ativa do objeto precisa ser codificada, mas a forma e posição também devem ser representadas.

O padrão inclui ferramentas para a codificação do formato de objetos retangulares e irregulares tanto na escala binária ou gray (semelhante a um canal alfa).

Esse conceito é mostrado na figura 10.

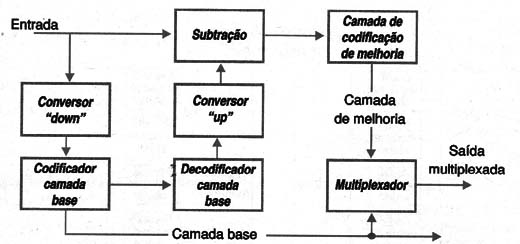

Escalabilidade

No contexto de compressão de mídia, escalabilidade significa a capacidade de distribuir o conteúdo de mais de um nível de qualidade dentro de uma mesma corrente de bits. MPEG-2 e MPEG-4 fornecem ambos os perfis escaláveis usando um modelo convencional.

Nele o codificador gera uma camada de base e uma ou mais camadas de melhoria, como mostrado na figura 11.

As versões mais recentes do MPEG-4 incluem um perfil de escalabilidade de grão fino (fine grain scalability – FGS).

Essa técnica gera uma corrente única de bits representando o nível de maior qualidade, mas que permite versões de menor qualidade que podem ser extraídas.

Outros Aspectos do MPEG-4

O MPEG-4 é enorme e os comentários que foram feitos apenas abordam alguns aspecto do padrão.

Existem perfis de estúdio para codificação de alta qualidade que, em conjunto com a codificação do objeto, permitem o armazenamento de todos os elementos separados de um sinal de vídeo composto.

Mais extensões do MPEG-4 podem proporcionar níveis de qualidade compatível com o cinema digital.

A figura 12 mostra os perfis do MPEG-4 definidos atualmente.

Alguns tipos de objetos definidos no MPEG-4 são interessantes.

Um exemplo é o “sprite”. Um sprite é um objeto de fundo estático, geralmente maior do que a parte visível ou display.

Por exemplo, a ação de um vídeo game pode ocorrer diante de uma cena de fundo.

O Futuro do MPEG-4

Como visto anteriormente, o MPEG-4 é uma ampla gama de padrões oferecendo capacidades muito ricas para muitas aplicações.

Essa é a teoria: na prática o MPEG-4 pode mostrar ter menos sucessos.

Em particular, muitos observadores esperavam que o MPEG-4 rapidamente se tornaria o mecanismo dominante de codificação para materiais audio-visual transmitido através da Internet e com isso substituir diversos Codecs licenciados em uso hoje.

No entanto, isso não ocorre, nem espera-se que vá ocorrer num futuro próximo.

Existem duas principais razões para que isso não aconteça.

A primeira é que a tecnologia e a performance resultante do MPEG-4 é que ela se baseia no H.26x desenvolvido pela ITU, que data dos anos 1990.

A distribuição de áudio e vídeo pela Internet é um negócio competitivo, e os maiores participantes como a Apple, Microsoft e RealNetoworks implementaram esquemas próprios de codificação de vídeo para superar o codec do MPEG-4.

A outra razão para a falha é a situação do licenciamento da patente. Até 2002, as empresas que desejassem implementar o MPEG4 não sabiam que tipo de royalties deveriam pagar aos donos das patentes.

O esquema proposto de licenciamento para os níveis básicos do MPEG-4 foram publicados depois e encontraram uma reação fortemente adversa da indústria.

MPEG-7

Como o MPEG-3 foi cancelado, a seqüência de padrões, MPEG-1, MPEG-2 e MPEG-4 é a que foi adotada.

Alguns participantes do comitê desejavam que o padrão seguinte da série fosse o MPEG-5.

Outros, atraídos pela conotação binária da série, acharam que o seguinte deveria ser o MPEG-8. Finalmente, concluiu-se que o seguinte seria o MPEG-7.

O MPEG-7 não trata apenas de compressão, mas sobre metadata. Metadata é a informação digital que descreve o conteúdo de outros dados digitais.

Na terminologia moderna o material de programa ou uma imagem de vídeo, áudio ou objetos de dado que veiculem informação, são conhecidos como “data essence” (essência de dados).

O metadata fornece todas as informações que se necessita sobre o que há nessa essência.

MPEG-21

O MPEG-21 novamente difere em espécie ao trabalho anterior do comitê.

O conceito básico é relativamente simples – através de uma vasta procura, o MPEG-21 visa criar uma estrutura completa para o manuseio e uso de itens digitais, incluindo todo suporte de infra-estrutura para transações comerciais e manuseio de direitos que precisam acompanhar essa estrutura.

A afirmação básica é “capacitar o uso transparente e aumentado de fontes de multimídia através de uma ampla faixa de redes e dispositivos”.

O escopo do MPEG-21 é indicado por 7 elementos de arquitetura definidos da seguinte forma:

1. A declaração de item digital é esperada para “estabelecer uma abstração flexível e uniforme e esquema interabilidade para definir itens digitais”. O esquema deve se aberto e extensível para toda e qualquer fonte de mídia e os esquemas de descrição e devem suportar uma estrutura hierárquica que seja de fácil procura e navegação.

2. A representação de item digital do MPEG-21 é a tecnologia que vai ser usada para codificar o conteúdo e proporcionar todos os mecanismos necessária para sincronizar todos os elementos do conteúdo. Espera-se que essa camada seja referência para pelo menos o MPEG-4.

3. Identificação digital de item e descrição que proporcionar o conjunto de bits para a identificação e descrição dos itens digitais (ligando todos os elementos do conteúdo). Esse item vai incluir esquemas de descrição do MPEG-7, mas precisa também incluir “novos sistemas de geração de identificação para suportar gerenciamento e informação efetivos, precisos e automatizados, regras de uso e monitoramento, etc. Deve satisfazer todas as necessidades dos usuários do MPEG-21.

4. Conteúdo de gerenciamento e uso que deve definir as interfaces e protocolos para armazenamento e gerenciamento de itens digitais MPEG-21. Deve suportar o arquivamento e catalogação do conteúdo, ao mesmo tempo preservando os direitos de uso e a capacidade de acompanhar mudanças para itens e descrições. Esse elemento do MPEG-21 deverá suportar uma forma de “trading” onde os consumidores podem trocar informações pessoais para o direito de acesso ao conteúdo, e mecanismo de formatação pessoal para “canais pessoais” e construções similares.

5. Proteção e Gerenciamento de Propriedade Intelectual é um componente essencial. As controvérsias que existem atualmente em relação aos arquivos de áudio MP3 demonstra a necessidade de novos mecanismos de copyrights capazes de operar no mundo digital. Pode-se argüir que o conteúdo não tem nenhum valor a não ser que ele seja protegido. O MPEG-21 será elaborado no trabalho que está sendo realizado com o MPEG-4 e MPEG-7, mas vai necessitar de extensões para acomodar novos tipos de itens digitais e novos mecanismos de fornecimento.

6. Terminais e Redes MPEG-21 vai endereçar o fornecimento dos itens numa ampla gama de redes e terá a capacidade de obter o conteúdo de uma ampla gama de terminais. Conceitualmente, um filme pode ser enviado em qualidade total de cinema digital para um cinema, ou com menor qualidade numa rede de velocidade mais baixa para um dispositivo de consumidor (a um preço diferente). Em ambos os casos, devem existir restrições quanto ao número e tipo de usos. O usuário deve se preocupar com nenhum problema de complexidade associada aos meios de envio e recepção.

7. Finalmente, existe a necessidade de um relato de evento para padronizada as medidas e interface de desempenho de todos os itens. O mais óbvio exemplo disso é que o sistema permita ao usuário acessar a um item protegido, mas que um pagamento apropriado seja feito.

Conclusão

Os padrões MPEG abrangem uma enorme quantidade de itens, conforme o leitor pode constatar por mais esse artigo de nossa série.

A evolução rumo a uma convergência, mostra que o MPEG também caminha rumo a uma utilização de uma forma mais ampla não só em TV digital, como também nos elementos que permitam o envio de programas através da internet. Nos outros artigos dessa série, iremos além abordando as diversas tecnologias estão associados ao envio dos sinais.

Índice

Introdução à TV Digital (CUR9000)