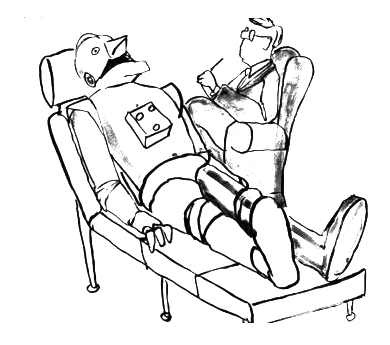

Em seu livro “Eu, Robô”, depois convertido em filme, Isaac Asimov aborda com bastante sutileza os problemas psicológicos que a inteligência artificial de um robô podem alcançar. Não há dúvida que o modo inteligente de pensar que temos apresenta propriedades muito pouco conhecidas apesar dos estudos de grandes nomes que partem de Freud e Jung. Como tudo isso pode implicar em problemas comportamentais de “criaturas” robóticas que tenham inteligência artificial é o que discutiremos neste artigo.

ART1811S

Não pretendemos ser exatos nem apresentar soluções, mas apenas levantar algumas indagações que podem se tornar alvo de estudos bastante complexos nos próximos anos.

Até que ponto os algoritmos de inteligência artificiais usados em cobots, chatbots e outros que tenham contato com humanos podem refletir problemas comportamentais dos humanos, gerados tanto pelo aprendizado direto como pela influência dos algoritmos programados?

Isso é algo interessante de se analisar. Se vamos introduzir numa inteligência artificiais um algoritmo que reflita, por exemplo nossos gostos e isso é feito por linhas de programa escritas por humano, até que ponto essas linhas podem transferir ao robô os comportamentos próprios do programador.

Por exemplo, ao programar as características de determinados legumes, o programador escreve num conjunto de linhas o que deve ser levado em conta pela inteligência artificial ao analisar tal legume num cardápio. Inconscientemente, entretanto ao chegar à beterraba (que ele não gosta) o número de propriedades programadas pode não ser o mesmo dos outros legumes. Ou ainda, ele pode inconscientemente incluir um pequeno detalhe que diferencia de modo negativa esse legume.

O resultado pode ser interessante. Mesmo sem nunca ter provado uma beterraba ou robô pode, “inconscientemente” ter uma pequena aversão por este legume. Um robô que não gosta de beterraba!

Mesmo durante sua experiência de aprendizado, colhendo informações de pessoas com que ele tem contato, o robô pode “somatizar” esse comportamento, e isso será refletido nas suas atitudes.

De forma muito estranha, veremos então que fazendo esse robô percorrer com uma cesta uma feira livre, ele “pulará” a banca de beterrabas! Como isso poderá ser explicado por um programador? Algo que no futuro pode ser muito interessante no comportamento geral de um robô que não pode ter nem gostos ou preferências.

A inteligência pode sim manifestar problemas comportamentais que até exigiriam uma análise “psíquica” do fenômeno. Viria o problema comportamento de um robô de seu programador, do ambiente em que ele colheu as informações que levaram ao aprendizado ou de outra forma não conhecida? Como corrigir isso?

Não é de hoje que existem “psicólogos” de computadores que analisam problemas de funcionamento de uma máquina que aparentemente nada tem a ver com o hardware e que não podem ser facilmente visualizados num software.

O “psicólogo” deve analisar o programa onde o problema se manifesta e procurara detectar pequenas falhas que podem levar a comportamentos estranhos. Por exemplo, o computador pode dar uma resposta errada quando determinado número é inserido num cálculo.

Talvez essa seja uma das profissões do futuro em que o engenheiro terá de estudar além de programação e hardware também Freud e Jung. Como juntar tudo isso é um problema para os futuros elaboradores dos currículos de nossas instituições de ensino, se bem que elas estão evoluindo bastante com a introdução de disciplinas como a inovação, a criatividade, etc.

O fato que á medida que os programas de inteligência artificial se tornam mais complexos, qualquer pequeno desvio de padrão que ocorra numa programação e num processo de aprendizado pode levar a comportamentos até perigosos. Os mesmos problemas que os humanos manifestam causando desvios capazes de nos tornar criaturas ameaçadoras podem aparecer nos robôs.

Não adianta neste caso as leis da robótica de Asimov para nos proteger. Os humanos deveriam seguir padrões de ética e moral ao dirigir suas atitudes na vida em sociedade, mas não é o que vemos. Na verdade, em nossos dias temos mais desvios do que normalidade.

Se não tomarmos cuidado com as máquinas inteligentes podemos criar monstros, cuja neutralização serão tanto mais difícil quanto mais poderes acumularem e quanto maior for o poder de convencimento que desenvolverem.

Cuidado! O robô tirano que vai governar o mundo pode estar sendo encubado em alguma inteligência artificial que aparecerá nos próximos anos.